AIは電気やインターネットのように、非常に便利なツールとして、あらゆる業界に大きな変化を与えていくでしょう。AIの恩恵を受ける一分野として医療分野が挙げられます。

今回は医療分野でのAI利用における課題と、今後AIと人間はどのように関わっていくべきかを中心にまとめていきます。

AIの超えるべき課題

AIが想定していない病気にどう対応するか

発熱や頭痛、鼻水が出た時、まず最初に考えるのは「風邪」でしょう。しかしもしかしたら風の初期症状と思われていたものが危険な疾患のサインだったり、他の感染症の合併が起きているかもしれません。

このように他の深刻な疾患を除外した上で風邪と診断するのは、現時点のAIにはとても難しいことです。

画像認識でレントゲンを読むAIは原則一つの疾患にしか対応できませんし、問診AIで絞られる範囲も限られています。

AIがそれぞれ全く別のアルゴリズムであり、1人で全ての判断を下しているわけではない以上、正確な診断には人間との共同作業が欠かせないと言えるでしょう。

AIによる誤診の責任は?

厚生労働省は「医療AIを使用した際の最終的な責任は医師にある」と明記しています。

いくら便利になっても医師は無批判にAIの診断を受け入れてはいけません。このように人間が負う責任が重すぎると、利用が委縮してしまったり、AI側の品質改善を妨げます。

だからといってAI開発者に責任を負わせるとなると、新しいAIの開発に積極的に取り組めなくなったり、医師がAIの誤診を防ぎにくくなってしまいます。

AI開発者と医師の間での最終的な責任の所在は解決しなけれはならない課題です。

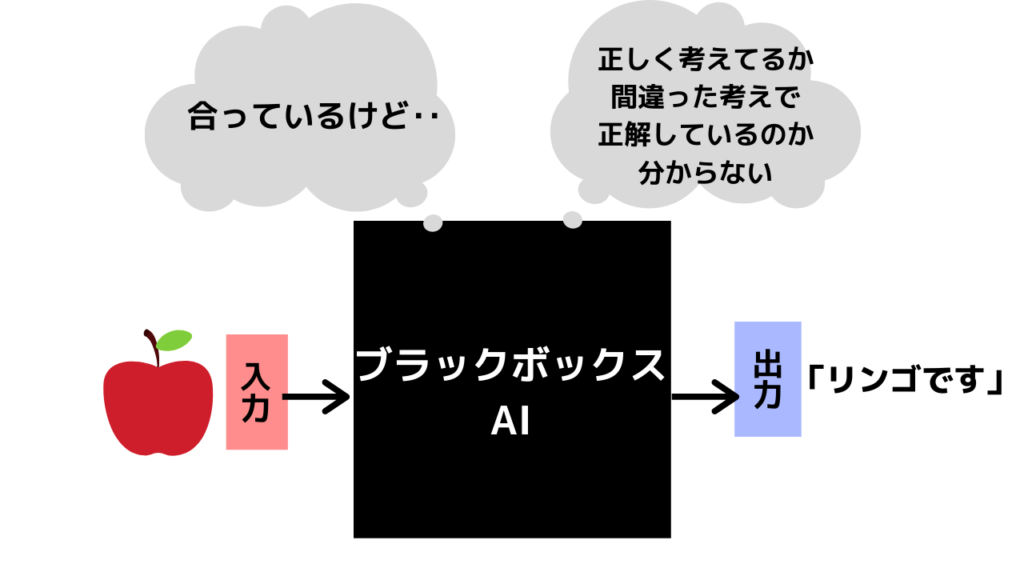

AIのブラックボックス化

現在のAIは「ディープラーニング」という技術によって発達してきました。ディープラーニングでは、機械が自ら膨大なデータを学習し自律的に答えを導き出します。

とても便利なディープラーニングですが、人間がプログラムしなくてもいいという特徴ゆえに、その思考プロセスを明らかにするのが難しいのです。

これにより、なぜAIがその結論を出したのか分からないという「AIのブラックボックス化」が問題となっています。

例えば「脳に5㎜の動脈瘤があり、破裂による出血のリスクがとても高いので手術しましょう」と言われれば納得できますが、思考プロセスを省いて「頭の手術が必要です」とだけAIに言われても困ります。

このようにAIの思考プロセスを人間が理解することができない状況は、医療という責任の大きな分野でのAI利用の足かせとなっています。

そこで取り組まれているのが「説明可能なAI」の開発です。説明可能なAIは文字通り、思考過程が人間にも理解できるAIのことです。

説明可能なAIについてより詳しく知りたい方は「説明可能なAIとは AIのブラックボックス化にどう対応する?」をご覧ください。

医療AIの現状

医療分野においてAI利活用の旗手を育成するために国が政策として進めているのが「AI病院」です。日本の医療AI利用を引っ張っていくと予想されるAI病院についてはこちらをご覧ください。

現在すでに医療AIは多くの分野で取り組みが行われています。ここでは「検査・診断」「治療・投薬」「介護」の三つの分野に分けて、各分野でのAI利用を見てきました。

まとめ:AIと人間の関わり方

今までのAIについて振り返ると、画像診断を筆頭に繰り返しの多い作業はAIにも代替可能でした。そのため、あるタスクだけに特化した職種はAIに代替可能だと言えるでしょう。

病理や放射線読影の医師は現在の画像診断中心の仕事から、より高度にAIを利用したり、AIの精度を高める側に回ることが予測されます。

しかし説明責任を始めとするコミュニケーションにおいて、人間の医師が果たす役割は変わりません。医師と患者の対話は今後も重要な医療行為として残り続けるでしょう。

医療の現場に「AIさえあれば人はいらない」という状況はあり得ません。AIは人間の代わりになるものではなく、別の視点から新しい知見を提供してくれる存在です。

それゆえに、これからの専門職ではAIについてより深く理解し、利用することが求められます。

コメント