AIは今最も注目されているテクノロジーの一つです。AIが社会へ普及するにはどのような壁を乗り越える必要があるのでしょうか。

AIの仕組みや詳細を復習したい方はこちら

2015年:人間以上の目をコンピュータが獲得。画像認識コンテストで人間より高い精度をたたき出したのです。

2016年:囲碁の世界チャンピオンがGoogleのアルファ碁というAIソフトに敗戦

2017年:プロ棋士がコンピュータ将棋ソフトに敗戦

このようにAIの発展はすごい速度で進んできましたが課題もあります。今回はその課題と解決策として、「説明可能なAI」についてお話していこうと思います。

AIのブラックボックス化

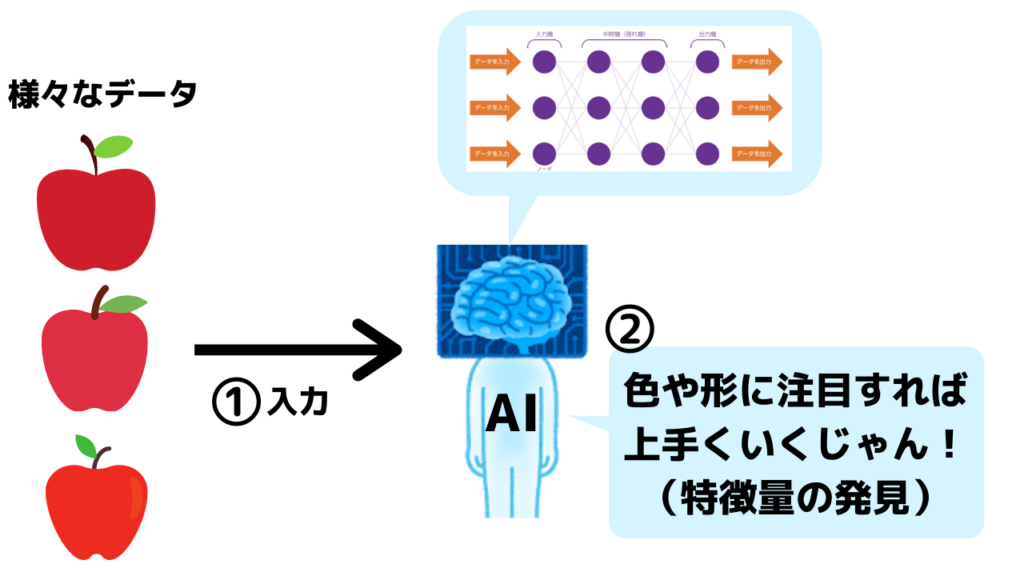

現在のAIは「ディープラーニング」という技術によって発達してきました。

ディープラーニングでは、機械が自ら膨大なデータを学習し自律的に答えを導き出します。

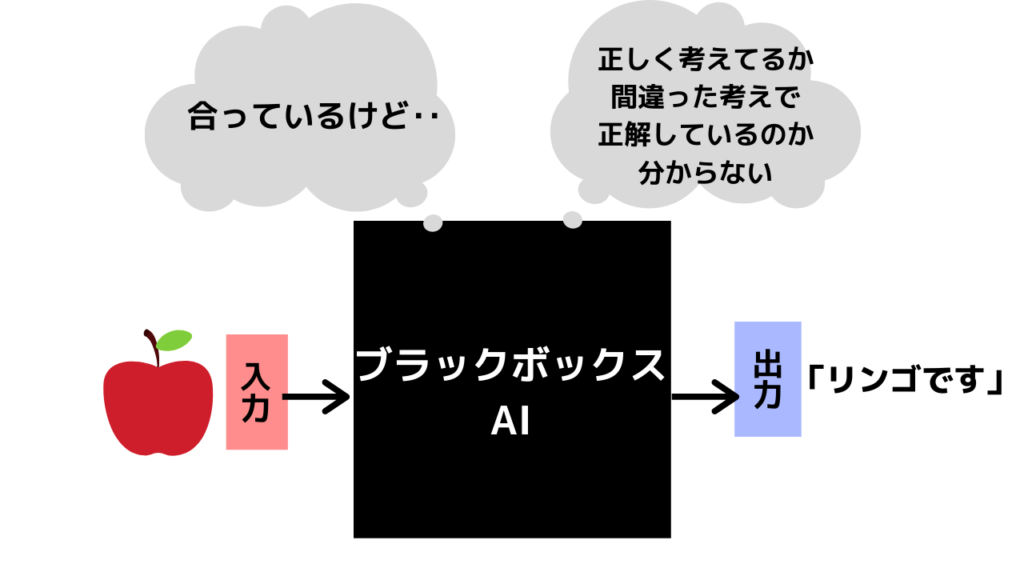

とても便利なディープラーニングですが、人間がプログラムしなくてもいいという特徴ゆえに、その思考プロセスを明らかにするのが難しいのです。

これにより、なぜAIがその結論を出したのか分からないという「AIのブラックボックス化」が問題となっています。

例えば「脳に5㎜の動脈瘤があり、破裂による出血のリスクがとても高いので手術しましょう」と言われれば納得できますが、思考プロセスを省いて「頭の手術が必要です」とだけAIに言われても困ります。

このようにブラックボックス化していることで下記のような問題が生じます。

- 改善点が分からず精度の向上ができない

- 安心感や納得感がない

- 説明責任を果たせない

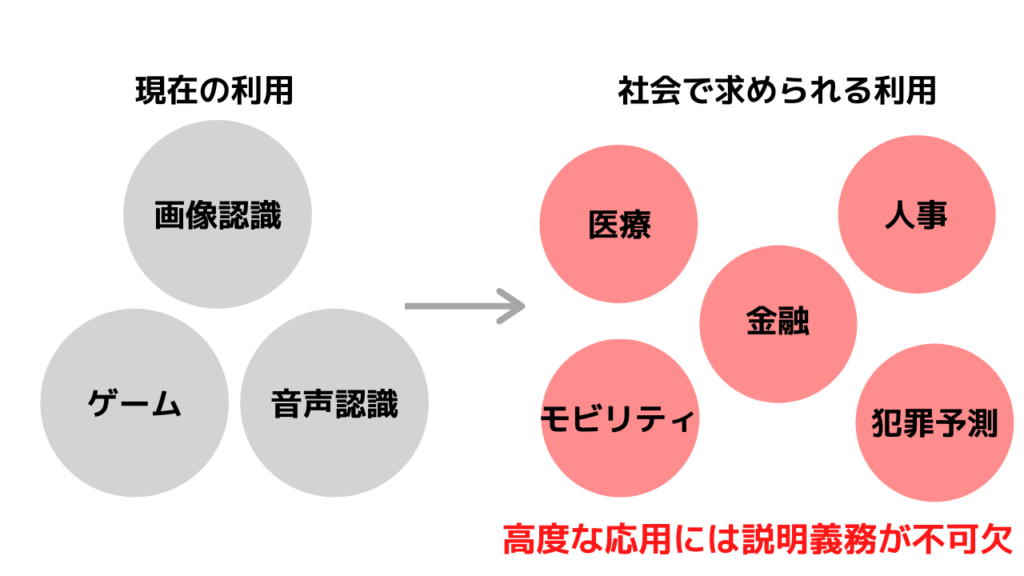

特に医療・金融・自動運転・経営など責任を伴う分野へのAIの導入は難しくなってしまいます。

説明可能なAIとは

社会で求められる分野にAIを応用するには、人間がAIが結論を導き出す過程をを理解・管理し、もしそれが間違っていたなら修正できるようにする必要があります。結論を導き出したプロセスを理解し、それが倫理規定やコンプライアンスに沿った方法で出された結論かどうかを判断しなければいけないからです。

この問題に対する答えとして注目されているのが説明可能なAI(Explainable AI,XAIとも呼ばれる)です。

説明可能なAIとは文字通りAI自身で「説明責任を果たせる」ような機械のことを指します。

説明可能なAIの出した結論は信頼することができるため、AIの利用範囲の拡大や、さらなる改善が期待できます。

説明可能なAIへのアプローチ

説明可能なAIには大きく分けて二つのアプローチ方法があります。

1.ディープラーニングを行うAIに説明機能を持たせる

一つ目のアプローチ方法はAIが結論と同時にその理由も自分で提示できるシステムを作ることです。

具体的には学習の過程にて特に大きな重みづけが行われた特徴量をニューラルネットワークから抽出し、判別の理由として示します。つまりどの変数が結果に最も寄与したのかを明らかにすることで、判断の理由とするのです。

人間が行う説明方法と似たようなものを新しくAIに学習させるのがこのアプローチ方法です。

2.ホワイトボックスAI

二つ目のアプローチ方法はホワイトボックスAIです。

こちらの方法は文字通りAI内部で実行されるプロセスの各ステップを可視化することが大きな特徴です。AIが説明してくれるわけではありませんが、判断の仕組みが分かるように学習モデルを新しく構築するという方法です。

AIのこれから

これからのAIはブラックボックスAIと説明可能なAIに二分化していくことが予想されます。

ブラックボックスAIは圧倒的な効率化を可能にするという強みがあります。生産工程の最適化やECの商品おすすめ、不良品発見など、説明がつかなくとも目的の達成に支障ない分野での利用は、効率のいいブラックボックスAIの独壇場になるでしょう。

説明可能なAIは人への高度な提案をする分野での利用が中心になります。犯罪予測、医療、金融など信頼の必要な分野で強味を活かすことができます。

説明可能なAIがブラックボックスAIを駆逐するわけではなく、適所適材な役割分担が行われるようになると考えられます。

説明可能なAIのハイプサイクル

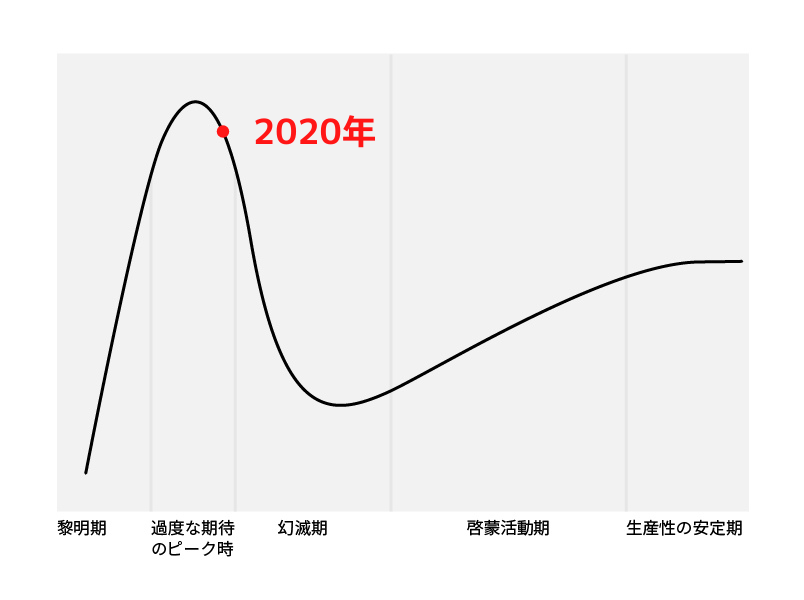

ハイプサイクルとはガードナーという会社が毎年発表する、「テクノロジーの地図」のようなものです。ハイプサイクルについて詳しくはハイプサイクルとは? ~現在のテクノロジーが一目で分かる~をご覧ください。

こちらが説明可能なAIのハイプサイクルです。

得られるデータが少なかったのですが、2020年は過度な期待のピーク期でした。

開発も社会への浸透もまだ時間がかかりそうですね。ガードナーによると生産性の安定期に入るまでは5年~10年はかかるようです。

まとめ

今回はAIのブラックボックス化と説明可能なAIについてのお話をしてきました。

説明可能なAIはまだ研究途上で、社会に影響を与えるような事例が誕生しているわけではありません。

しかしディープラーニングによる高度な処理を社会に実装していくにあたって非常に大切な要素となるため、今後も注視していきたいですね。

コメント